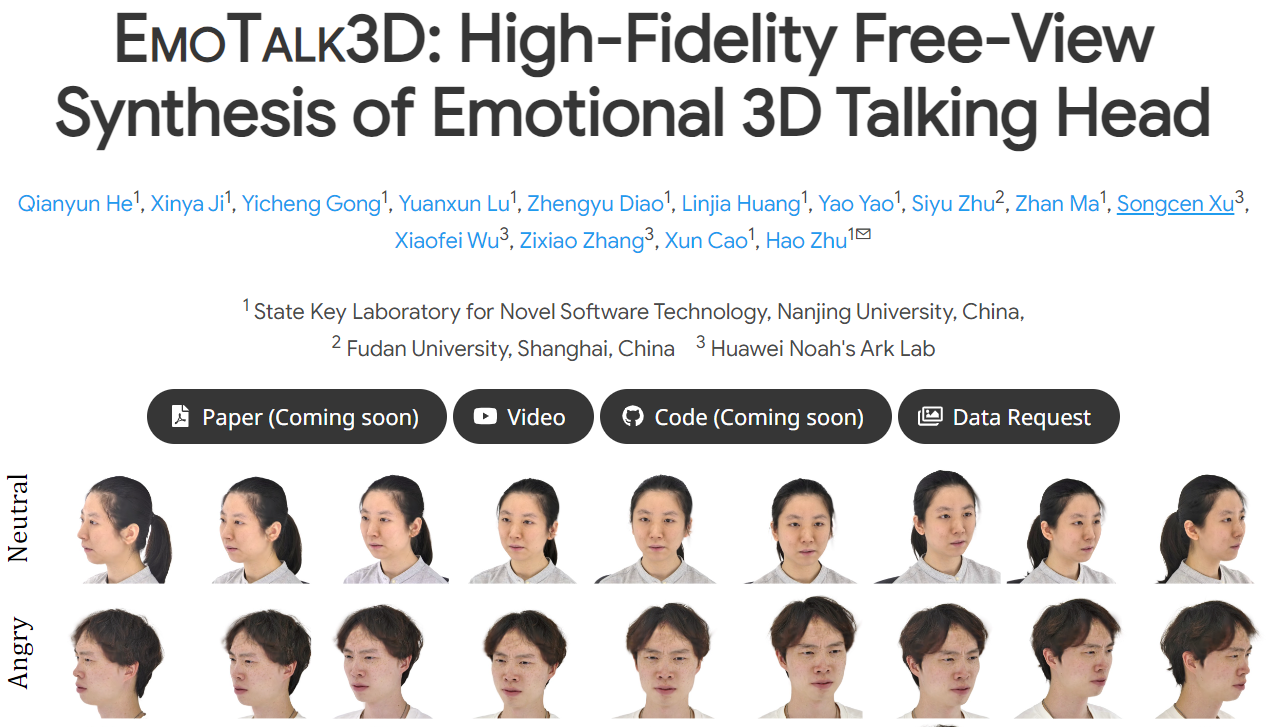

EmoTalk3D是一个用于合成具有可控情绪表达的高保真3D会说话头像的工具。

详细介绍:

主要功能:

EmoTalk3D能够根据输入语音合成具有丰富情感表达的3D头像动画。

它通过一个新颖的"Speech-to-Geometry-to-Appearance"映射框架,首先从音频特征预测精确的3D几何序列,然后合成3D头像的外观。

使用方法:

该工具的训练基于EmoTalk3D数据集,该数据集包含多视角视频、情绪注释和逐帧3D几何数据。

用户可以通过该工具提供的管道,包括情绪内容分离编码器、语音到几何网络(S2GNet)、高斯优化和补全模块、几何到外观网络(G2ANet)以及渲染模块,来生成3D会说话头像。

适用场景:

适用于电影、游戏和虚拟现实等领域中的动画制作和角色设计。

也适用于需要模拟真实人类情绪反应的人工智能交互系统。

适用人群:

动画设计师、游戏开发者和虚拟现实内容创作者。

从事人工智能和人机交互研究的科研人员。

优缺点介绍:

优点:

提供了一种新颖的方法来生成具有多视角一致性和情感表达的3D会说话头像。

能够捕捉到动态的面部细节,如皱纹和微妙的表情。

支持可控的情绪表达,提高了渲染质量和唇部运动的稳定性。

缺点:

目前数据集尚未公开,需要等待官方发布数据请求方法。

作为新工具,可能需要用户熟悉其特定的工作流程和技术要求。

分类标签推荐:

三维建模、动画制作、人工智能、情感合成、虚拟现实

开源的图像生成基础模型,拥有 170 亿参数,能够在短时间内生成高质量的图像,达到行业领先的图像生成水平。