Cherry Studio 是一款开源、可本地部署的“多模型 AI 超级工具箱”,用图形化方式把大语言模型、知识库、绘画、搜索等能力整合到一台电脑上。

一、主要功能

-

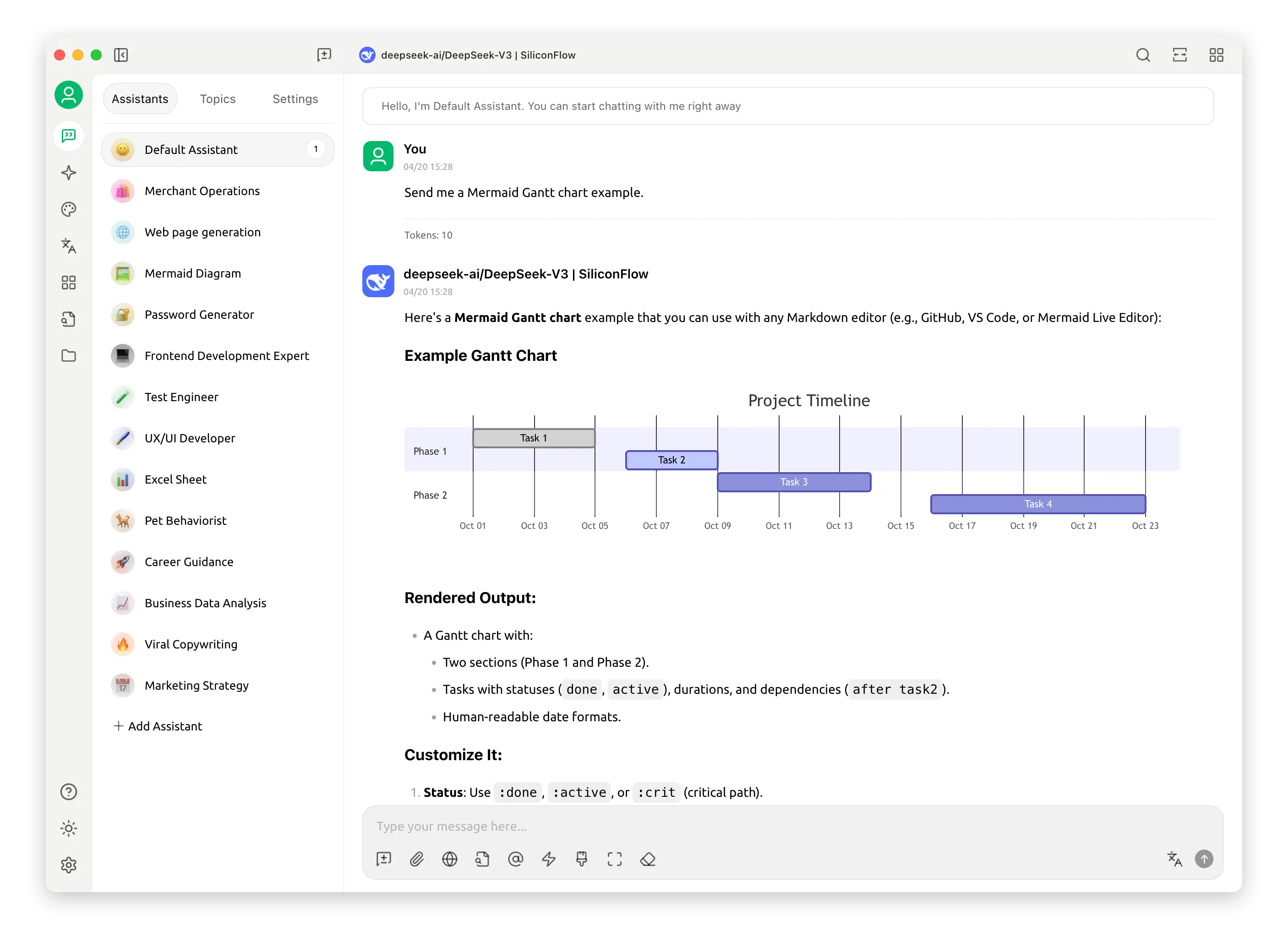

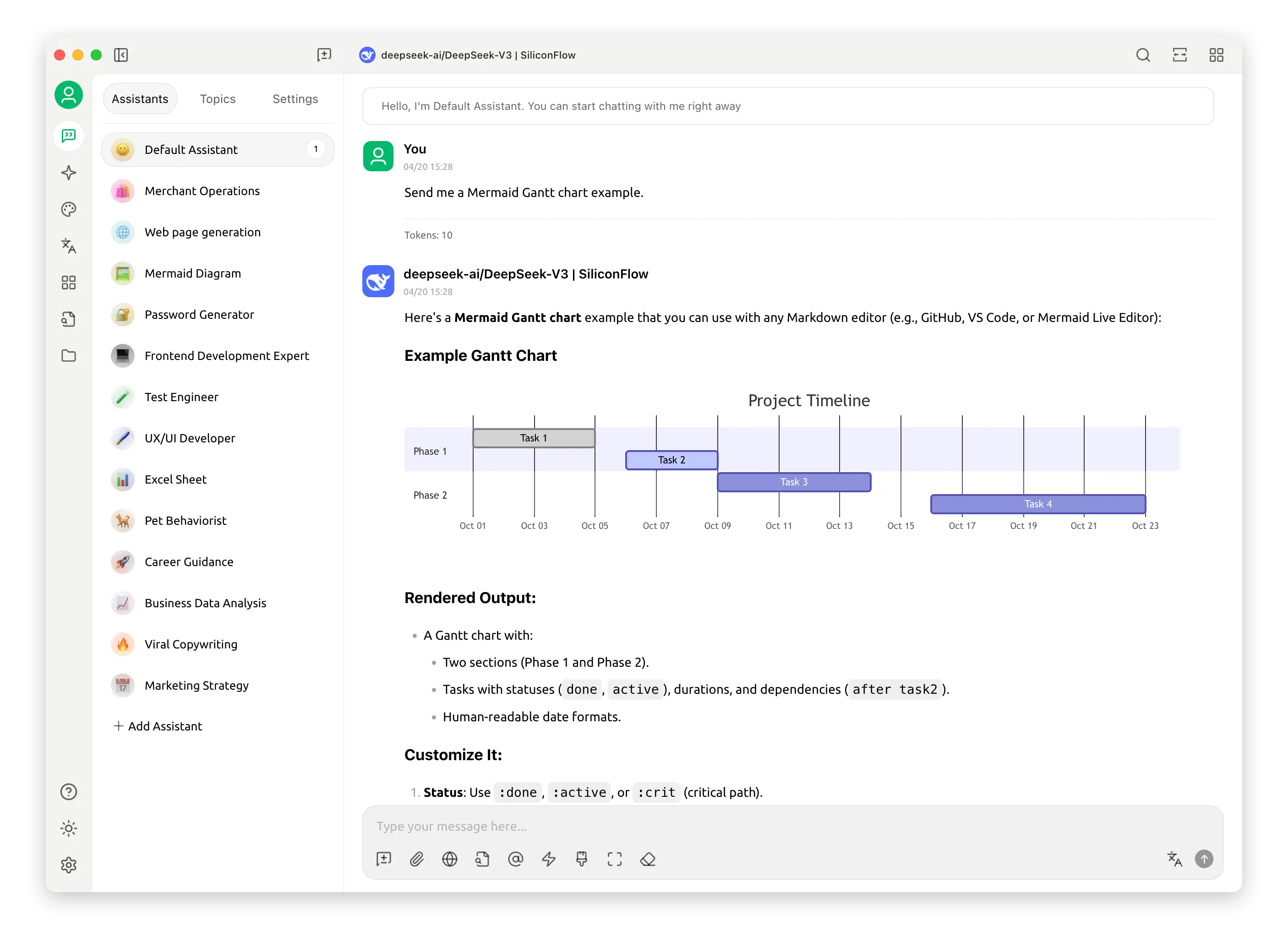

多模型对话:一键切换 300+ 云端/本地模型(OpenAI、Gemini、DeepSeek、Ollama 等),支持流式输出与参数微调。

-

智能知识库:把 PDF、DOCX、网页、PPT 拖进去即可构建私有向量库,基于 BGE-M3 嵌入 + Chroma 实现语义检索,问答准确率提升 60% 以上。

-

实时联网搜索:内置 Tavily / OpenRouter,自动抓取最新网页、论文、行情,再让模型总结答案。

-

AI 绘画与创作:集成 Stable Diffusion、DALL·E,支持文生图、图生图、LoRA 模型;自带 Markdown + 公式 + 代码高亮 + 实时预览编辑器。

-

MCP 插件生态:图形化安装 MCP 服务,可“零代码”连接数据库、Git、Slack、Blender 等外部工具。

-

企业安全:AES-256 本地加密 + TLS1.3 传输 + WebDAV 增量备份;支持 TPM 硬件密钥与 IP 级访问策略。

-

跨平台与离线运行:Windows / macOS / Linux 一键安装,断网也能用本地模型与知识库。

二、技术原理

-

统一模型路由:AiProviderNew 类封装不同厂商 SDK,结合动态 QoS 策略,50 ms 内完成模型选择。

-

流式响应:基于 Server-Sent Events 实现逐字返回,可随时中断与重试。

-

RAG 增强:BGE-M3 多语言嵌入 → Chroma 向量存储 → 混合检索(语义 + 关键词),最后由大模型生成答案。

-

本地加密链:TPM 生成根密钥 → AES-256-GCM 文件级加密 → 内存零落盘,性能损耗 <3%。

-

插件隔离:MCP 服务跑在独立容器/进程,通过 JSON-RPC 与主进程通信,崩溃不影响主程序。

三、应用场景

-

个人超级助理:写报告、做翻译、画插图、整理读书笔记,全部离线完成。

-

企业知识客服:把内部制度、产品手册建成知识库,对外提供 7×24 精准问答。

-

开发者辅助:代码生成、Bug 解释、自动补注释,还能通过 MCP 直接操作 Git、Jira。

-

教育与科研:批量读论文、生成思维导图、实时联网查最新期刊。

-

内容创作:一键出多语言脚本、配图、视频分镜,支持多模型对比选最优稿。

四、使用方法

-

下载安装:官网或 GitHub 下载对应系统安装包,双击完成。

-

首次启动:选择“本地模式”或“混合模式”,程序自动下载嵌入模型与默认 LLM。

-

添加模型:在“模型市场”输入 API Key 即可接入云端模型;或点击“本地模型”→“一键拉取 Ollama”。

-

建立知识库:侧边栏“知识库”→“新建”→拖拽文件→等待向量化完成即可问答。

-

安装插件:打开“插件中心”,浏览 MCP 服务,点“安装”后图形化配置参数即可生效。

-

高级设置:支持自定义模型路由规则、备份策略、主题与快捷键,全部在“偏好设置”中完成。

五、适用人群

-

极客与隐私控:希望数据不出本地、又能玩转多模型。

-

职场写作者:需要快速出文案、翻译、配图、PPT。

-

企业 IT/HR/客服:想低成本搭建私有化问答系统。

-

教师与学生:批量读文献、生成笔记、做可视化报告。

-

开发者:需要代码辅助、数据库操作、自动化脚本。

六、优缺点介绍

优点

优点

-

完全开源免费,可商用;

-

本地部署,数据自主可控;

-

300+ 模型 + MCP 插件,扩展性极强;

-

图形化界面,零代码即可配置;

-

社区活跃,更新周期 2–4 周。

缺点

-

本地跑 7B 以上大模型需 16 GB+ 显存,老电脑性能受限;

-

初期向量化大文件耗时较长(可后台运行);

-

MCP 生态仍在快速迭代,个别插件稳定性一般;

-

中文文档与视频教程相对较少,新用户需摸索。

开源大模型客户端、本地知识库工具、AI 写作助手、AI 绘画工具、MCP 插件平台

AutoGLM 2.0 是一款由智谱 AI 发布的革命性产品,用户只需通过语音指令,即可代替双手操控全网,实现多种复杂操作。