近日,蚂蚁集团正式开源发布全模态大模型Ming-Flash-Omni 2.0。该模型在视觉语言理解、语音可控生成、图像生成与编辑等多项公开基准测试中表现优异,部分指标超越谷歌Gemini 2.5 Pro,成为当前开源全模态大模型的性能新标杆。作为业界首个支持全场景音频统一生成的大模型,其以"可复用底座"形式向开发者开放,标志着国产多模态AI技术迈入全球领先行列。

一、核心技术突破:全模态能力全面领先

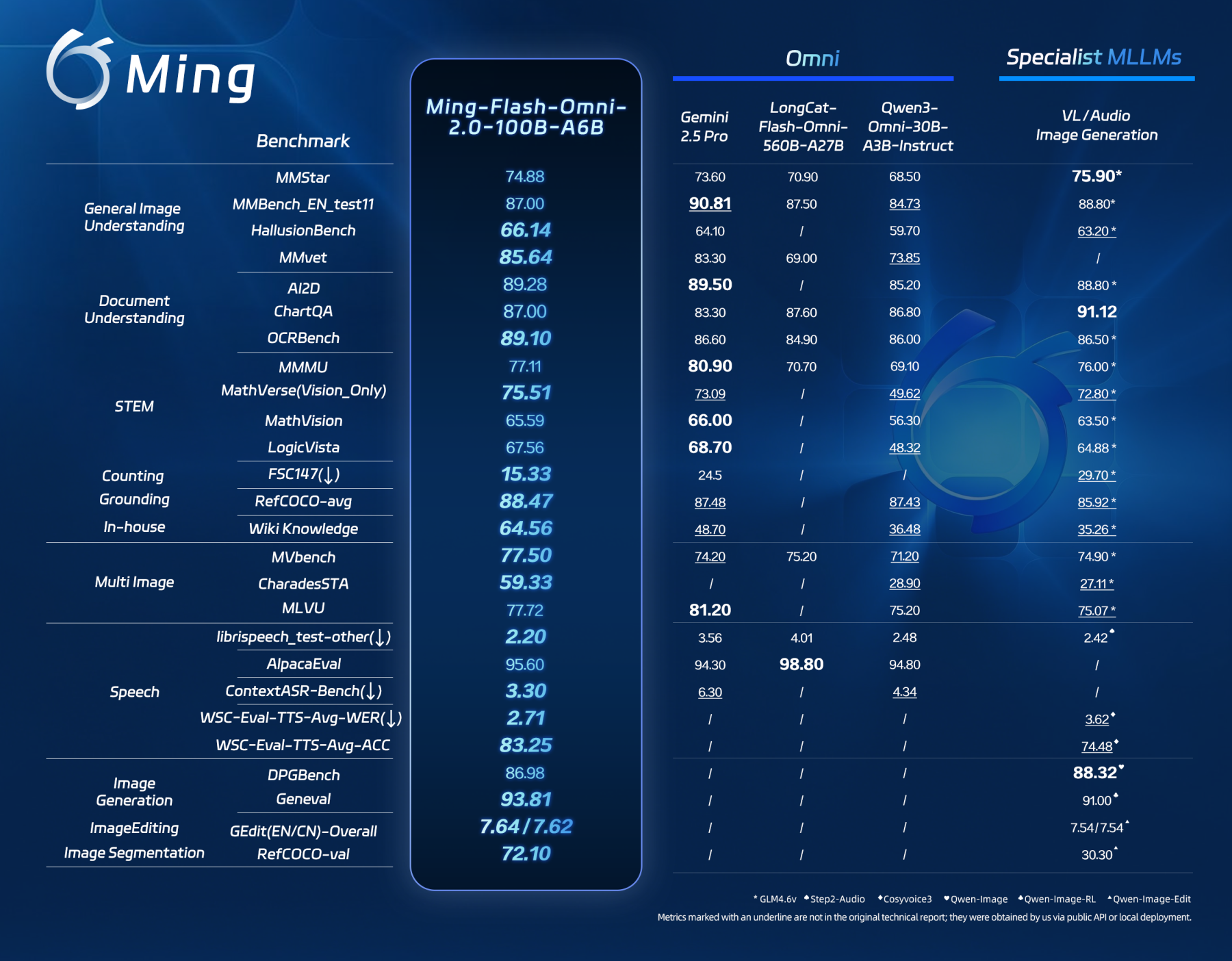

Ming-Flash-Omni 2.0基于Ling-2.0架构(MoE,100B-A6B)构建,围绕"看得更准、听得更细、生成更稳"三大目标进行系统性优化。在视觉理解方面,模型融合亿级细粒度标注数据与难例增强训练策略,显著提升对近缘动植物种类、精密工艺细节及稀有文物等高难度对象的识别精度,在HallusionBench、MMvet等测评中超越Gemini 2.5 Pro。在图像生成与编辑领域,该模型支持光影调整、场景替换、人物姿态优化等复杂操作,并能保持动态场景中的画面连贯性与细节真实度。

二、业界首创:全场景音频统一生成

作为业界首个全场景音频统一生成模型,Ming-Flash-Omni 2.0实现了技术路径的创新突破。该模型可在同一条音轨中同时生成语音、环境音效与音乐,用户仅需通过自然语言指令即可对音色、语速、语调、音量、情绪及方言等参数实现精细化控制。更值得关注的是,模型在推理阶段实现3.1Hz的极低帧率,支持分钟级长音频的实时高保真生成,在推理效率与成本控制上保持业界领先地位。此外,其具备的零样本音色克隆与定制能力,为个性化语音应用开发提供了全新可能。

三、开源生态构建:降低多模态应用开发门槛

此次开源意味着蚂蚁集团将核心能力以"可复用底座"形式全面开放。开发者可基于同一套框架复用视觉、语音与生成能力,显著降低多模型串联的复杂度与成本,为端到端多模态应用开发提供统一入口。目前,模型权重与推理代码已在Hugging Face等开源社区发布,用户亦可通过蚂蚁百灵官方平台Ling Studio在线体验。百灵模型负责人周俊表示,未来团队将持续优化视频时序理解、复杂图像编辑与长音频生成实时性,完善工具链与评测体系,推动全模态技术在实际业务中规模化落地。