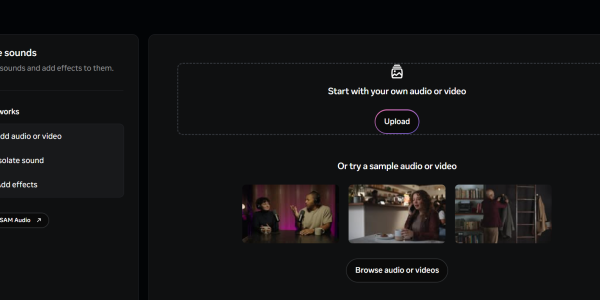

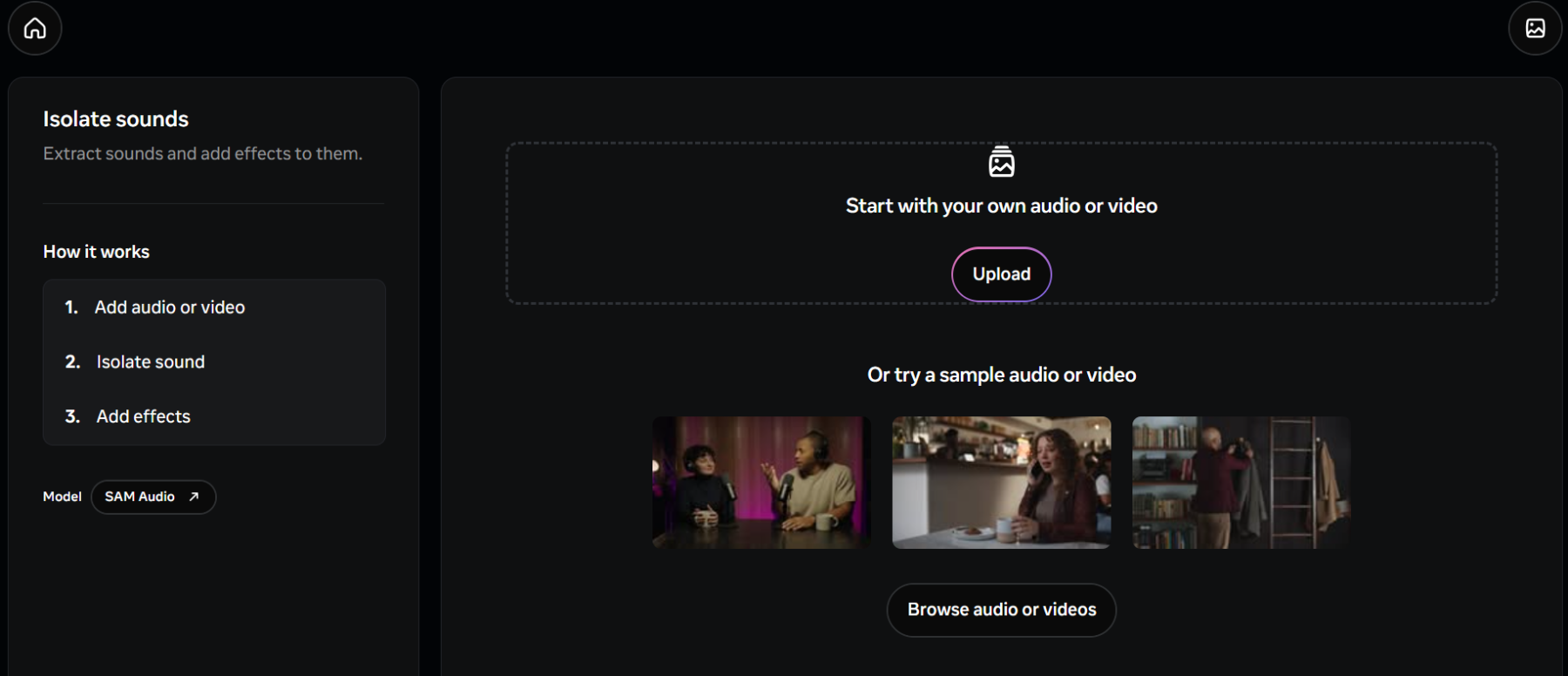

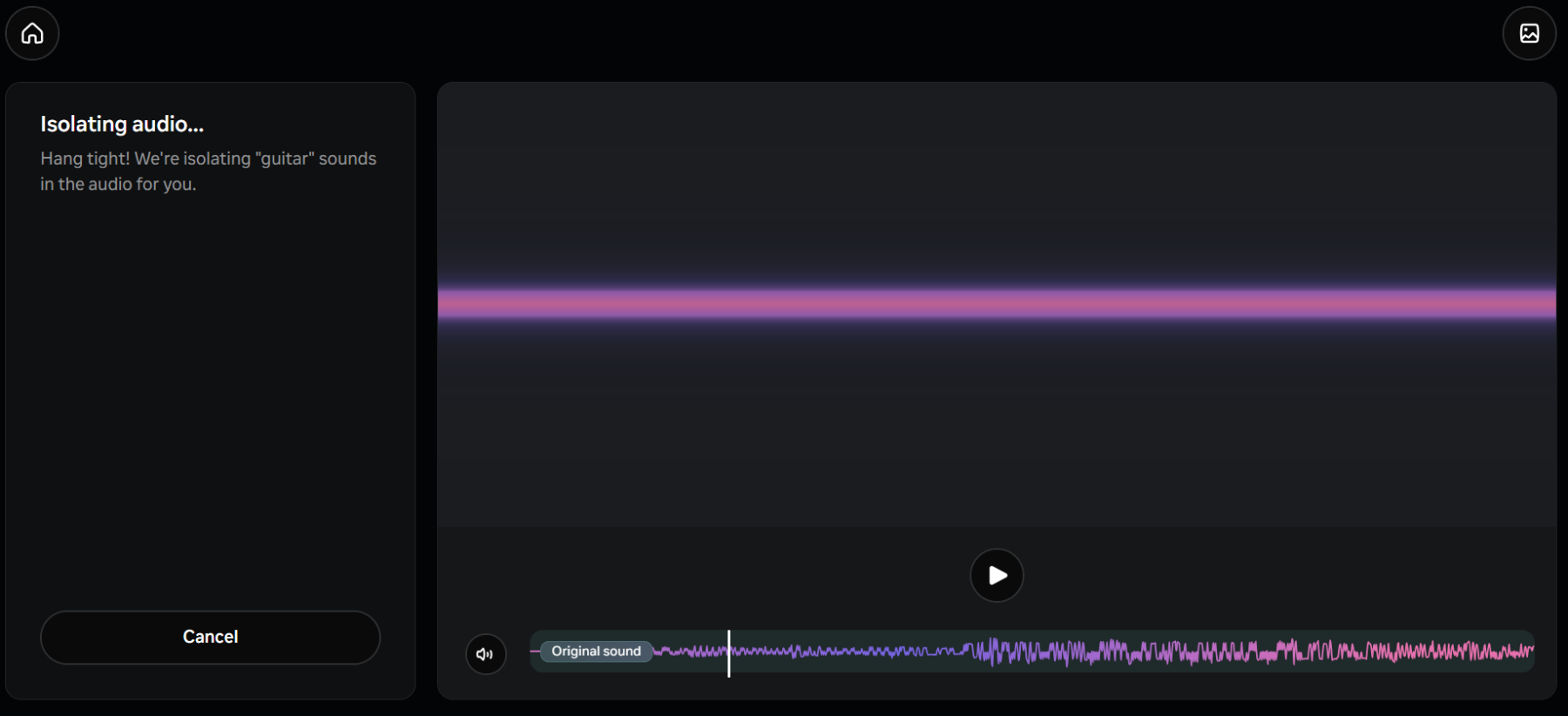

近日,Meta正式推出音频处理领域的重磅突破——SAM Audio,这是全球首个统一的多模态音频分离模型。该模型能让用户像“用眼睛听声音”一样,从一段混杂的视频或音频中,一键提取出任意目标声音。例如,点击视频中的吉他手,可立刻分离出纯净吉他声;输入“狗吠”,能自动过滤掉整段播客中的犬吠噪音。这项技术首次将人类自然感知声音的方式完整复刻到AI系统中,具有革命性的意义。

一、技术原理与创新

SAM Audio的核心是其自研的感知编码器视听(PE-AV),被Meta称为模型的“耳朵”。该引擎基于今年4月开源的Meta Perception Encoder计算机视觉模型扩展而来,首次将高级视觉理解能力与音频信号深度融合,实现跨模态的声音定位与分离。具体而言,SAM Audio支持三种直觉化交互方式,可单独或组合使用:

文本提示:输入“人声演唱”“汽车喇叭”等语义描述,自动提取对应声源。

视觉提示:在视频画面中点击发声物体(如说话的人、敲鼓的手),系统即分离其音频。

时间片段提示(行业首创):标记目标声音出现的时间区间(如“3分12秒到3分18秒”),模型自动处理整段录音中的同类声音。

二、性能与效率

SAM Audio基于流匹配扩散Transformer的生成建模框架,结合PE-AV作为核心引擎。PE-AV利用PyTorchVideo、FAISS和对比学习,在超过1亿视频上进行大规模多模态对比学习训练。在通用音频分离任务上,SAM Audio显著超越现有SOTA模型,并可匹配领域特定模型表现。模型推理速度快于实时(RTF≈0.7),支持500M至3B参数规模。

三、应用场景与合作

SAM Audio旨在赋能音频清理、背景噪声移除、乐器分离等创意工具开发。Meta已与美国助听器制造商Starkey合作探索潜在的集成,同时还与2gether-International(一个为残疾创业者提供服务的加速器)合作,探索其在辅助技术中的应用潜力。此外,为推动技术标准化,Meta同步开源两大关键工具:

SAM Audio-Bench:首个基于真实场景的音频分离评测基准。

SAM Audio Judge:首个基于感知标准、无需参考音轨的自动化评估模型。

尽管SAM Audio取得了重大突破,但Meta也承认其存在一些局限性。例如,分离“高度相似的音频事件”仍然是一个挑战,比如从众多声音中挑出一个声音或从管弦乐队中隔离单一乐器。此外,SAM Audio无法在没有提示的情况下完成任何音频分离,也不能将音频作为提示。不过,Meta正在积极改进这些不足,并探索更多应用场景,以充分发挥SAM Audio的潜力。